Ⅰ. Abstract

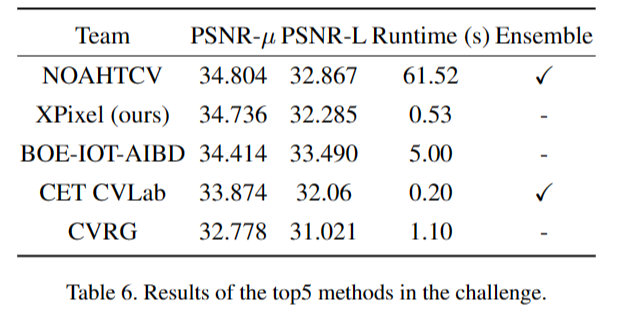

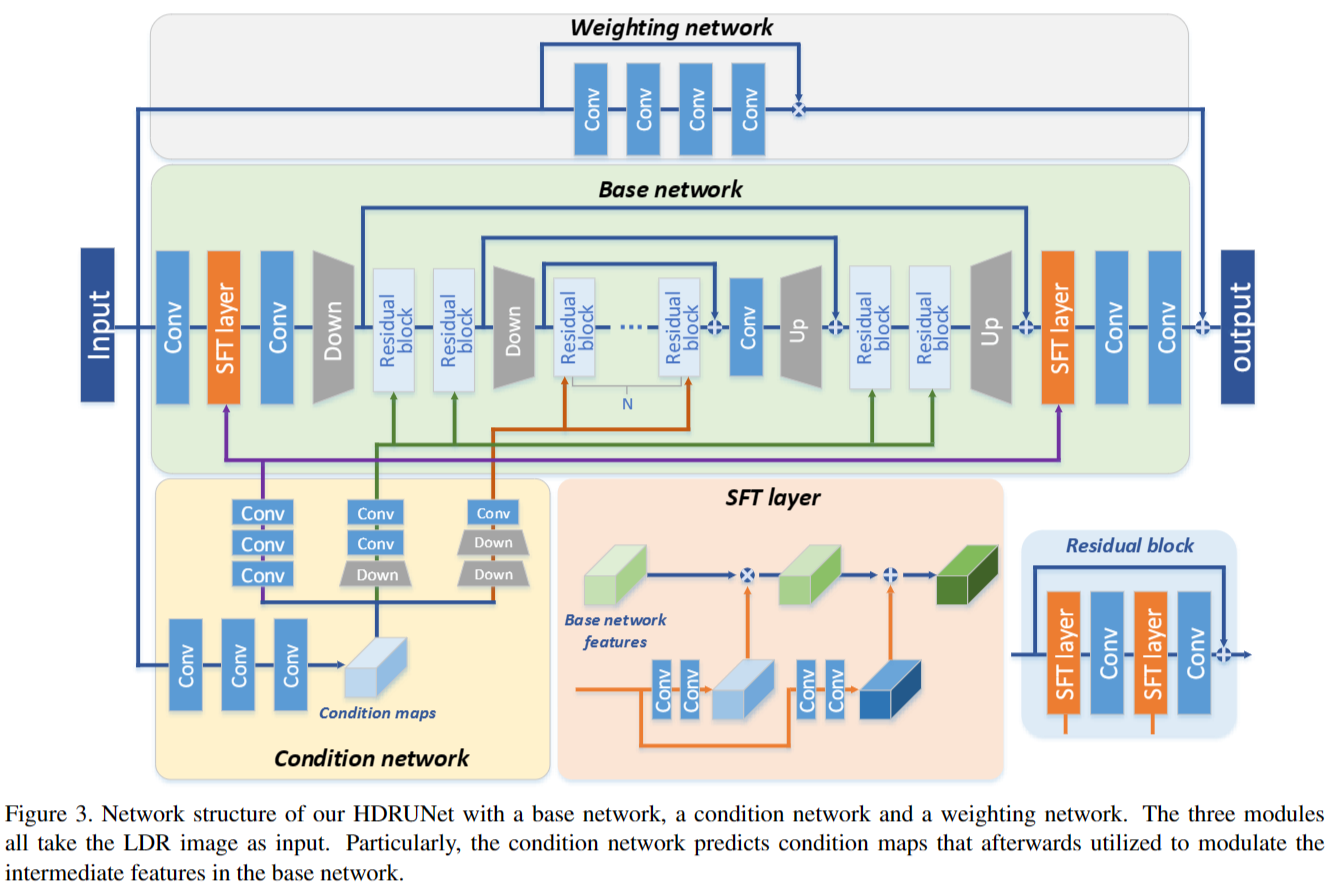

Most consumer-grade digital cameras can only capture a limited range of luminance in real-world scenes due to sensor constraints. Besides, noise and quantization errors are often introduced in the imaging process. In order to obtain high dynamic range (HDR) images with excellent visual quality, the most common solution is to combine multiple images with different exposures. However, it is not always feasible to obtain multiple images of the same scene and most HDR reconstruction methods ignore the noise and quantization loss. In this work, we propose a novel learning-based approach using a spatially dynamic encoder-decoder network, HDRUNet, to learn an end-to-end mapping for single image HDR reconstruction with denoising and dequantization. The network consists of a UNet-style base network to make full use of the hierarchical multi-scale information, a condition network to perform pattern-specific modulation and a weighting network for selectively retaining information. Moreover, we propose a T anh L1 loss function to balance the impact of over-exposed values and well-exposed values on the network learning. Our method achieves the state-of-the-art performance in quantitative comparisons and visual quality. The proposed HDRUNet model won the second place in the single frame track of NITRE2021 High Dynamic Range Challenge. The code is available at https://github.com/chxy95/HDRUNet.

由于受限于消费级数码相机的传感器性能,它们在真实世界中只能拍摄有限亮度范围的图像,并且在成像过程中会引入噪声和量化误差。为了获得高动态范围图像,以展示更广泛的亮度范围,目前的方法通常要合成多个曝光的图像。然而,获取相同场景的多曝光图像非常具有挑战性,而且现有的高动态范围(HDR)图像重建方法通常忽略了噪声和量化损失的处理。

为了解决这些问题,我们提出了一种新的学习方法,称为HDRUNet。它使用空域动态编解码网络来端到端地学习图像的映射,同时处理噪声和量化误差。这个网络包括一个基础网络,它以UNet的风格来利用多尺度的层次信息;一个条件网络,用于执行模式相关的调制;以及一个加权网络,用于自适应选择要保留的信息。

此外,我们引入了Tanh_L1损失函数,以平衡过度曝光和正常曝光的影响。我们的方法在量化性能和视觉质量方面取得了业界领先的性能。在NTIRE2021单帧高动态范围竞赛中,我们的HDRUNet获得了第二名的出色成绩。

Ⅱ. Contributions

在这项工作中,我们的目标是在从单个 8 位 LDR 噪声图像进行伽马校正后预测非线性 16 位 HDR 图像。我们提出了一种空间动态编解码器网络,称为HDRUNet,用于处理曝光不足/过度曝光区域的恢复细节,以及整个图像的去噪和去量化。我们基于两个观察结果设计了我们的方法。首先,与HDR GT相比,LDR图像中噪声和量化误差肯定存在,过度曝光区域的模式与曝光良好的区域模式明显不同。其次,噪声分布是空间变化的,不像高斯白噪声那样均匀。为了解决这些问题,我们首先设计了一个由三部分组成的网络,包括一个可以利用多尺度信息的类UNet基础网络、一个对不同模式进行空间动态调制的条件网络和一个自适应保留输入信息的加权网络。此外,我们提出了一种新的 TahL1 损失函数,它将值归一化为 [0, 1],以平衡训练期间高亮度值和其他值的影响,以防止网络只关注高亮度值。

-

我们提出了一种新的深度网络,从单个LDR图像重建出具有去噪和去量化的高质量HDR图像。

-

我们为该任务引入了一个 TahL1 损失。与其他常用的图像恢复损失相比,这种损失可以带来更好的量化性能和视觉质量

-

实验表明,我们的方法在定量和定性上都优于最先进的方法,我们在NTIRE2021 HDR挑战赛的单帧赛道中获得了第二名

Ⅲ. Methodology

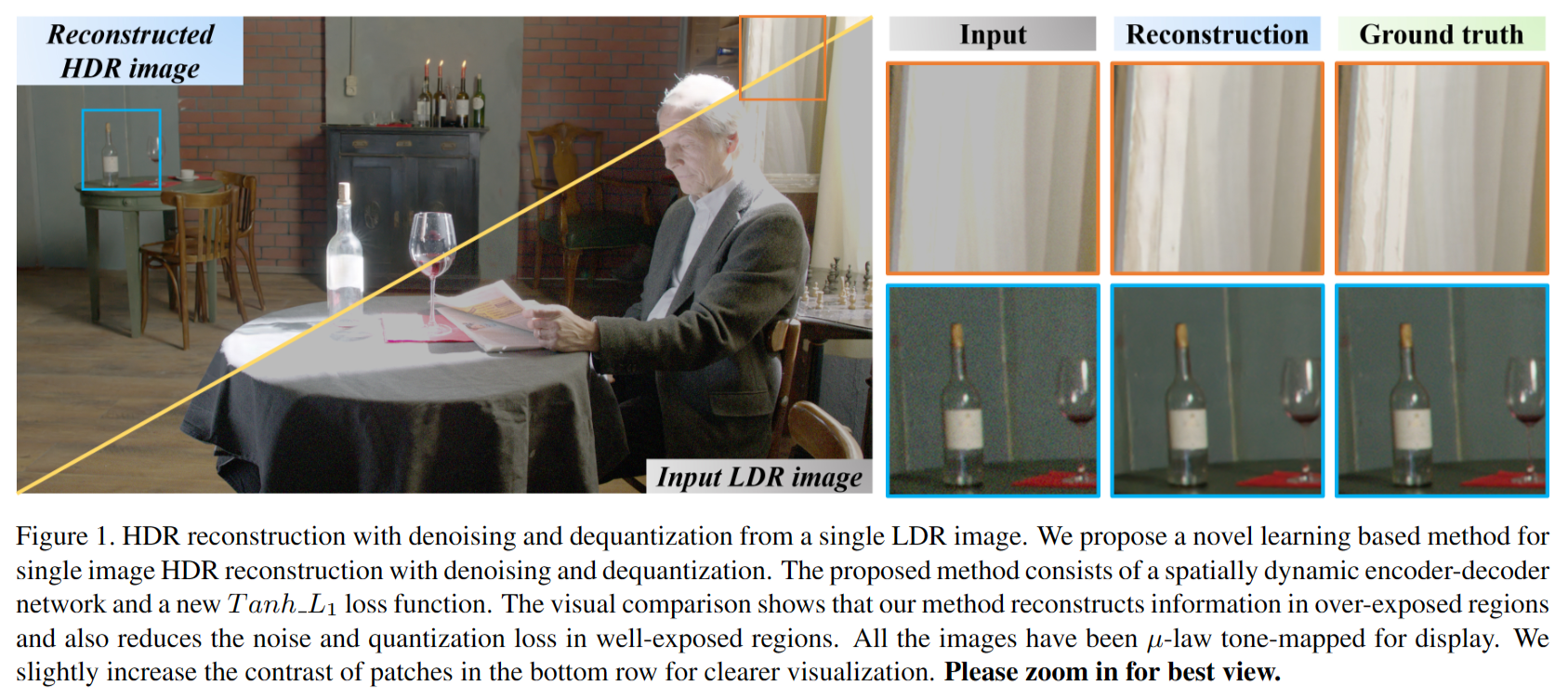

Observations

通常,在进行图像高动态范围(HDR)重建时,我们需要应对噪声降低和反量化(去量化)问题。为了阐明这个情况,我们对低动态范围(LDR)图像和其对应的HDR图像之间的梯度图进行了可视化,如下图所示。

根据上图观察结果,我们可以得出以下结论:

- 由于动态范围的压缩和量化过程,LDR图像中的高光区域梯度几乎不可见,相较于HDR图像存在很大的差异。

- 在正常曝光区域,LDR图像和HDR图像都显示出清晰可见的噪声梯度,表明两种类型的图像都受到噪声的影响。然而,它们的噪声模式存在显著差异,这可能是由于噪声水平的不同引起的。

此外,这些图像中的噪声并不均匀分布,这与通常的高斯白噪声不同。因此,噪声模式的差异不仅存在于明亮和暗部区域,还存在于正常曝光区域。这启发了我们设计一种称为“空域可变调制模块”的方法来应对这些差异。

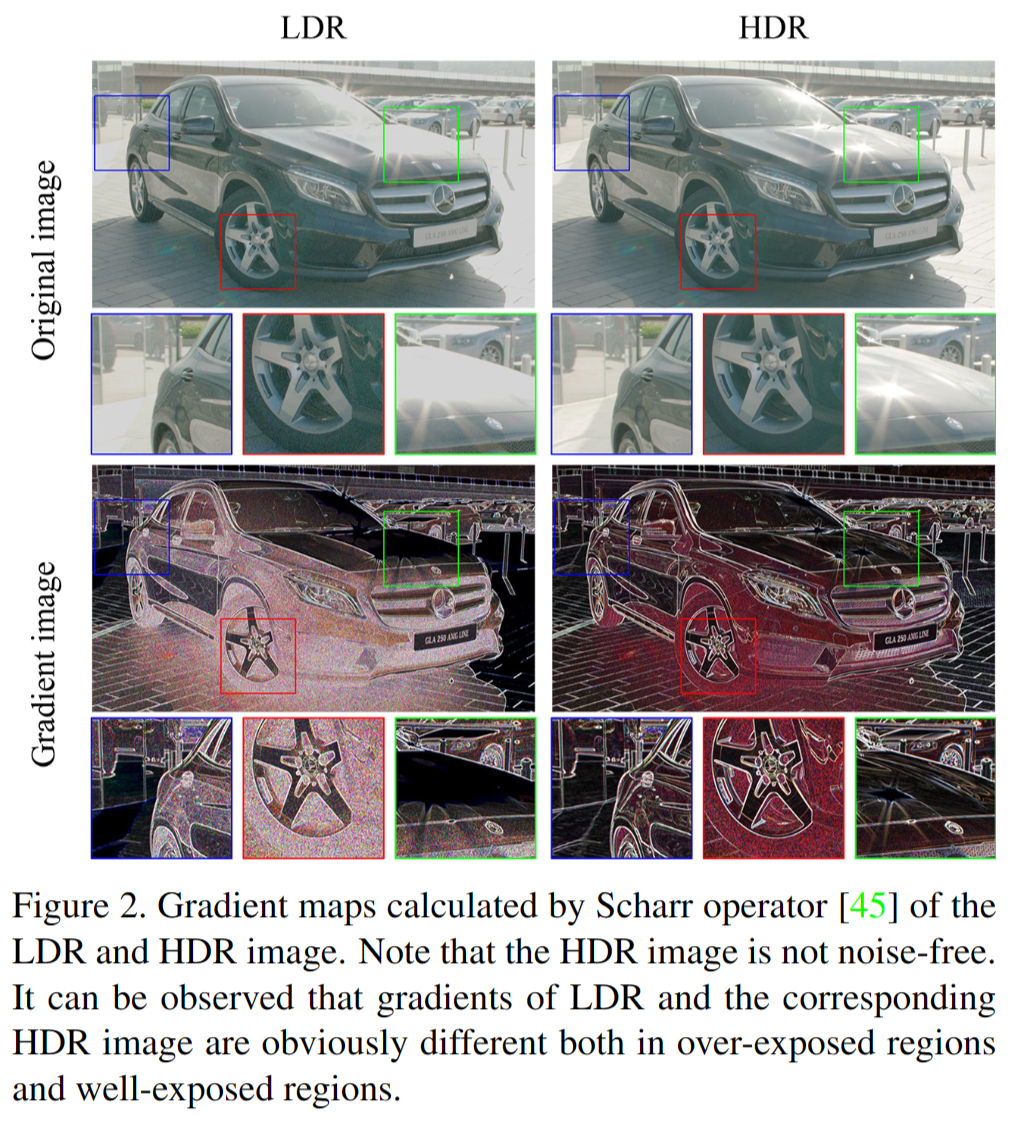

Network Structure

根据之前的观察和分析,我们开发了一种具备空域调制功能的UNet风格网络,用于单帧高动态范围(HDR)图像重建。以下是我们设计的网络结构示意图,它包括三个主要组成部分。接下来,我们将详细介绍这三个组成部分。

基础网络(Base Network)

基础网络采用了UNet风格的结构,接受8位带噪的LDR图像作为输入,并重建为16位的HDR图像。预测的HDR图像应该在过曝和欠曝区域包含更多细节,同时具有更少的噪声。

条件网络(Condition Network)

HDR图像重建的关键问题在于如何重建输入LDR图像中的过度曝光和欠曝光区域中的丢失细节。不同区域拥有不同的曝光亮度,不同的区域也具有不同的整体亮度和对比度信息。因此,采用位置相关和图像相关的方法进行图像处理非常重要。此外,网络还需要能够有效处理非均匀分布的噪声。然而,传统的卷积神经网络(CNN)通常采用空间不变性,也就是使用相同的滤波器权重来处理所有图像和所有位置。

受到CSRNet和SFTGAN的启发,我们提出了一种带有SFT(Spatial Feature Transform,空间特征转换)的条件网络,用于提供空域可变的调制。具体来说,条件网络以LDR图像作为输入,预测相应的条件映射图,并将其用于调制基础网络的中间特征。条件网络和SFT的机制在上图中进行了说明,其公式定义如下:

通过利用该调制策略,所提方法可以达到位置相关、图像相关的调制处理。

权重网络(Weighting Network)

HDR图像重建的主要挑战在于恢复过度曝光和欠曝光区域的细节,而大多数正常曝光的内容对网络的学习贡献非常小。因此,我们引入了一个估计网络,用于预测一个软加权图(W),以确定哪些区域需要在最终的HDR图像中保留。这样,整个网络可以重点关注过度曝光区域的细节重建。

注:I表示LDR输入,$ Y $表示最终重建的HDR图像,$ G $表示BaseNet的输出。

损失函数(Loss Function)

在真实场景图像的HDR重建中,我们需要同时考虑动态范围的重建以及降低噪声和量化伪影。然而,现有的损失函数(如L1和L2)并不适用于同时解决这些问题。直接作用于HDR数值的损失函数会过分关注高亮区域,而低估低亮区域,导致较差的量化性能和视觉质量。

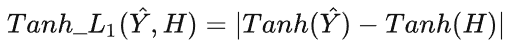

为了解决这个问题,我们提出了一种新的损失函数:Tanh_L1,其定义如下:

Ⅳ. Experiments

Experimental Setup

数据集(Dataset)

我们使用了NTIRE2021 HDR竞赛的数据集进行训练,该数据集包括1494对LDR/HDR图像,用于训练,60张LDR图像用于验证,以及201张LDR图像用于测试。需要注意的是,LDR/HDR图像对在时间轴和曝光等级方面进行了对齐,并经过伽马校正后保存。

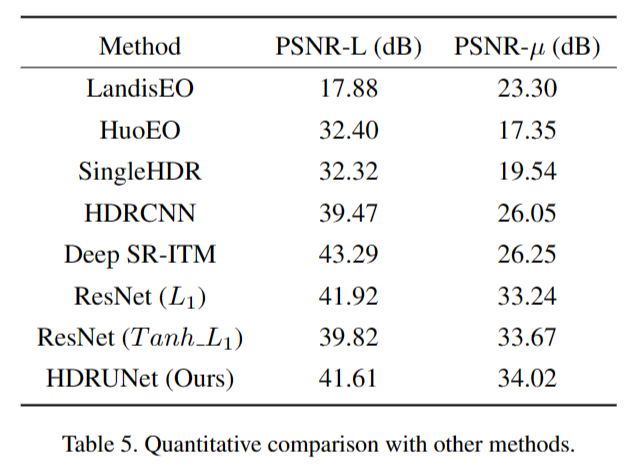

度量准则(Metrics)

我们选择了PSNR-L和PSNR-u作为评估标准。其中,PSNR-L更加注重高亮值的准确性,而PSNR-u更加关注图像的视觉相似性。因此,我们主要关注后者作为主要的评估标准。

细节(Details)

在后续的实验中,我们的网络采用了8个残差模块,使用stride=2的卷积进行下采样,而使用pixelshuffle进行上采样。在训练开始之前,我们对数据进行了预处理:将图像裁剪成大小为480×480的块,间隔步长为240。在训练过程中,每个批次的大小为16,我们使用Adam优化器和Kaiming初始化,初始学习率为2×10^-4,每2×10^5次迭代减半学习率。在以256×256大小的块进行训练时,整个训练过程耗时5天。

Ablation Study

我们先来看一下不同配置的影响,包含训练块尺寸、损失函数以及调制策略。

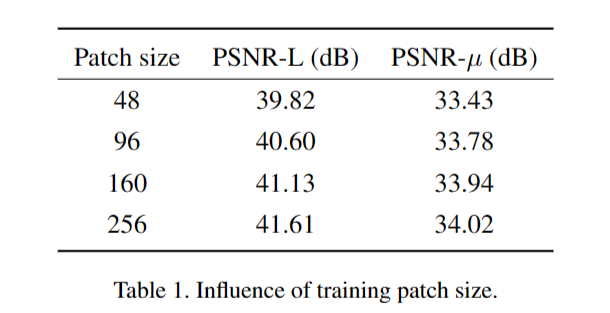

块尺寸(Patch Size)

实际上,对于这个任务来说,训练块的尺寸对结果影响非常显著。HDR重建不仅涉及局部处理,还包括更重要的全局和整体调制,因此不同区域需要不同的处理方式。此外,由于过度曝光区域的信息严重丢失,我们认为这些区域的细节重建需要更大的感受野。

在上表中,我们展示了不同尺寸的块对模型性能的影响。可以看到,随着块尺寸的增大,模型的量化性能逐渐提高。考虑到性能和计算资源之间的权衡,我们建议选择256×256作为训练块的尺寸。

-

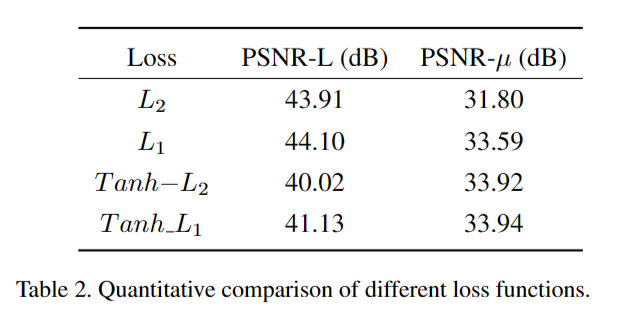

损失函数(Loss Function)

在前面的章节中,我们提出了用于带降噪与反量化的HDR重建的Tanh_L1损失。为了加速训练,我们将块的尺寸固定为160×160。在上表中,我们比较了不同损失函数对性能的影响,可以看到以下情况:

- 相对于L2损失,L1损失在量化性能方面表现更佳,即PSNR-L和PSNR-u指标更高。

- 通过引入Tanh操作,PSNR-u指标进一步提高,尽管PSNR-L略微下降。具体而言,使用Tanh_L1损失可以将PSNR-u指标提高高达0.5dB。这是因为,当直接使用L1和L2损失时,高亮区域的损失权重较大,导致更高的PSNR-L指标。然而,PSNR-u更能反映视觉相似性,而该竞赛也以此作为主要评估标准,因此我们选择了Tanh_L1作为损失函数。

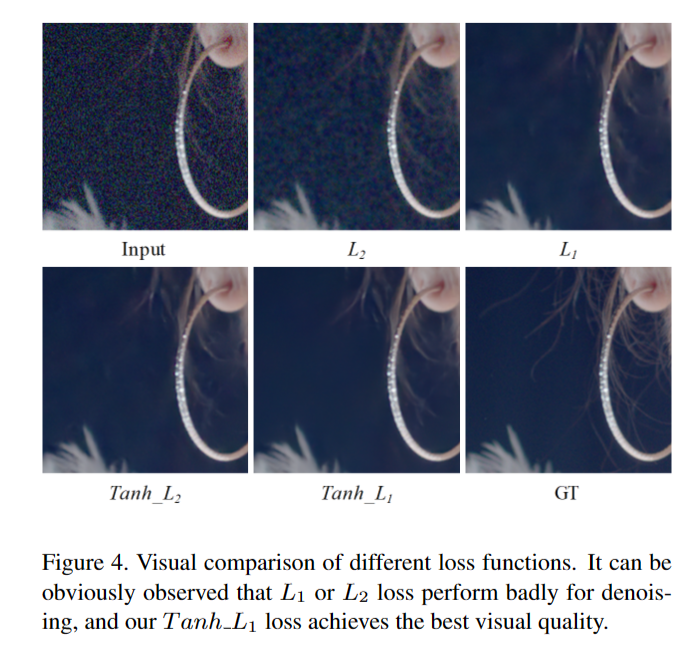

此外,损失函数对于视觉质量影响也很大,见上图。可以看到:L2与L1损失函数在正常曝光区域降噪性能交叉;相反,Tanh_L1损失取得了最佳视觉质量。

-

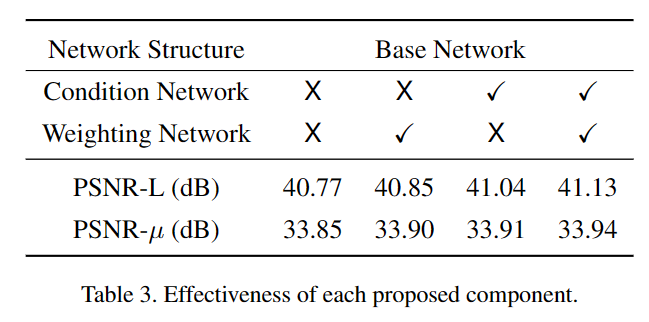

关键模块的有效性(Effectiveness of Key Modules)

接下来,我们验证了提出的关键模块的有效性,具体结果如上表所示。可以总结如下:

- 当只使用BaseNet时,PSNR-L和PSNR-u指标分别为40.77dB和33.85dB。

- 添加Weighting Network后,模型性能略微提高,分别提高了0.08dB和0.05dB。

- 添加Condition Network后,模型性能明显提高,分别提高了0.27dB和0.06dB。

- 使用所有模块后,模型指标进一步提高,达到了41.13dB和33.94dB。

这些结果表明,加入Weighting Network和Condition Network以及其他模块的组合,能够有效提升模型的性能,使其在PSNR-L和PSNR-u指标上都表现更好。

-

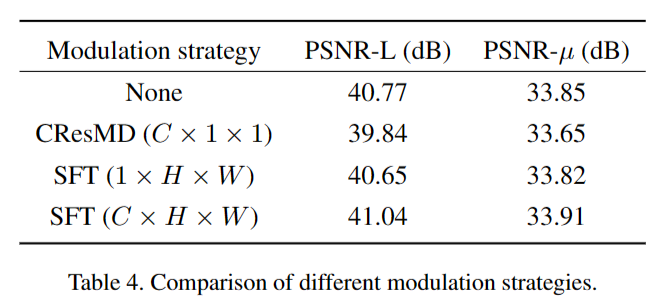

特征调制策略的探索(Exploration on Modulation Strategy)

在之前的研究中,CSRNet和SFTGAN等方法已经验证了特征调制的有效性。我们同样采用了SFT(Spatial Feature Transform)来提供空域可变调制。此外,我们还比较了其他特征调制策略的效果,具体结果如上表所示。总结如下:

- 全局通道调制对HDR重建的影响非常小,甚至可能导致性能下降。

- 引入SFT显著提高了模型的性能,分别将PSNR-L和PSNR-u指标提升到41.04和33.91dB。

这些结果表明,SFT的引入对HDR重建任务有着显著的正面影响,相对于全局通道调制等策略,它更适合这一任务,能够有效提升性能。

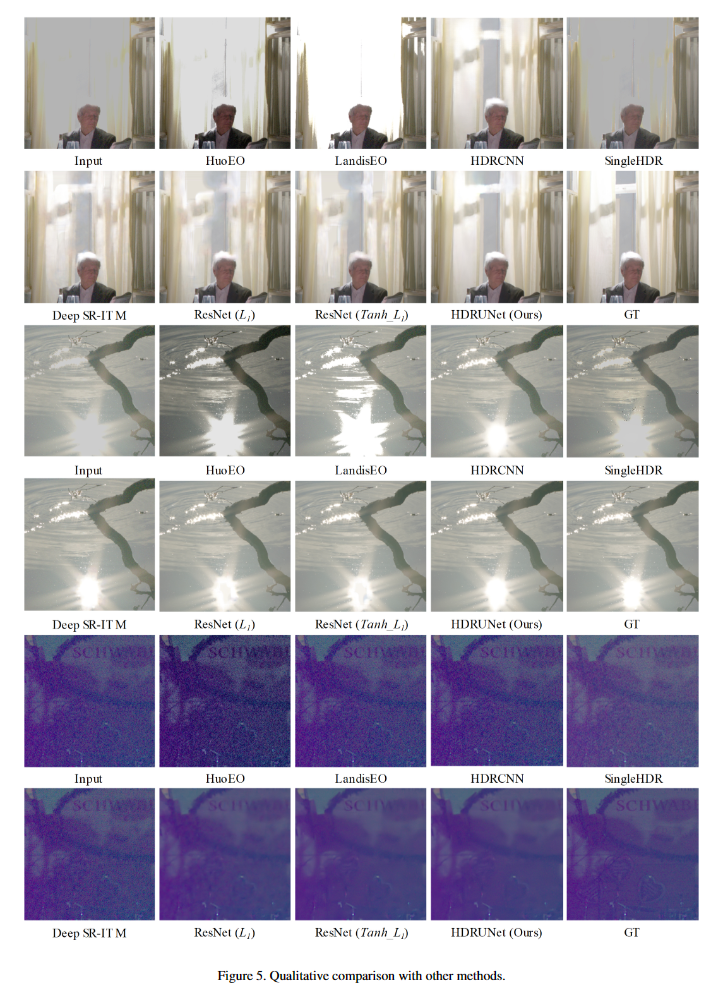

Comparison with State-of-the-art Methods

Results of NTIRE2021 HDR Challenge